为了提供儿童安全保护,Apple今日就宣布了将在iOS、iPadOS等系统引入三项儿童保护政策,以帮助用户在设备上查找儿童性虐待内容(CSAM),其中这三项措施就包括自动检测iMessage敏感照片 、iCloud儿童性虐待内容检测,以及Siri和搜索功能。

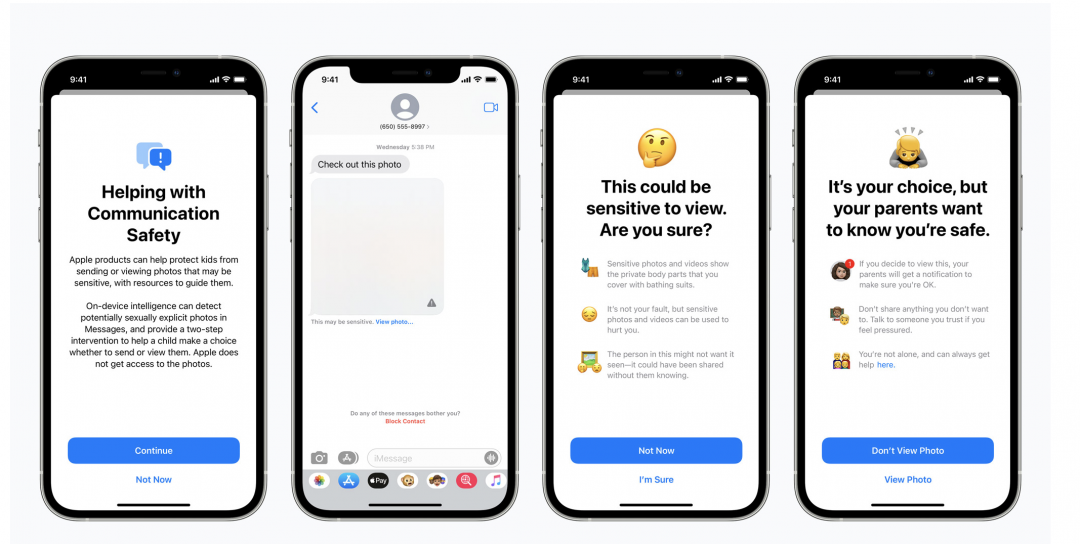

自动检测iMessage敏感照片

Apple在iMessage推出了通信安全功能,若有绑定家庭账号,当小孩收到色情的内容时,图片将会进行模糊处理,并跳出警告,父母也会同步收到通知。如果小孩想要发送色情的照片时,也会有相同的防护措施,父母也会收到一样的内容,不过这项功能仅适用于13岁以下的孩子。

当孩子点击查看敏感照片时,系统将跳出一则消息,告知照片被判定为敏感的原因。Apple将借由机器学习功能来分析图片,并确定照片是否包含色情内容。因为iMessage是端到端加密的,因此Apple也无法查看用户的信息内容。

此功能将率先在美国推出,过后将在iCloud中为家庭账户开放,并在最新版本的 iOS 15、iPadOS 15 和 macOS Monterey 中推出。

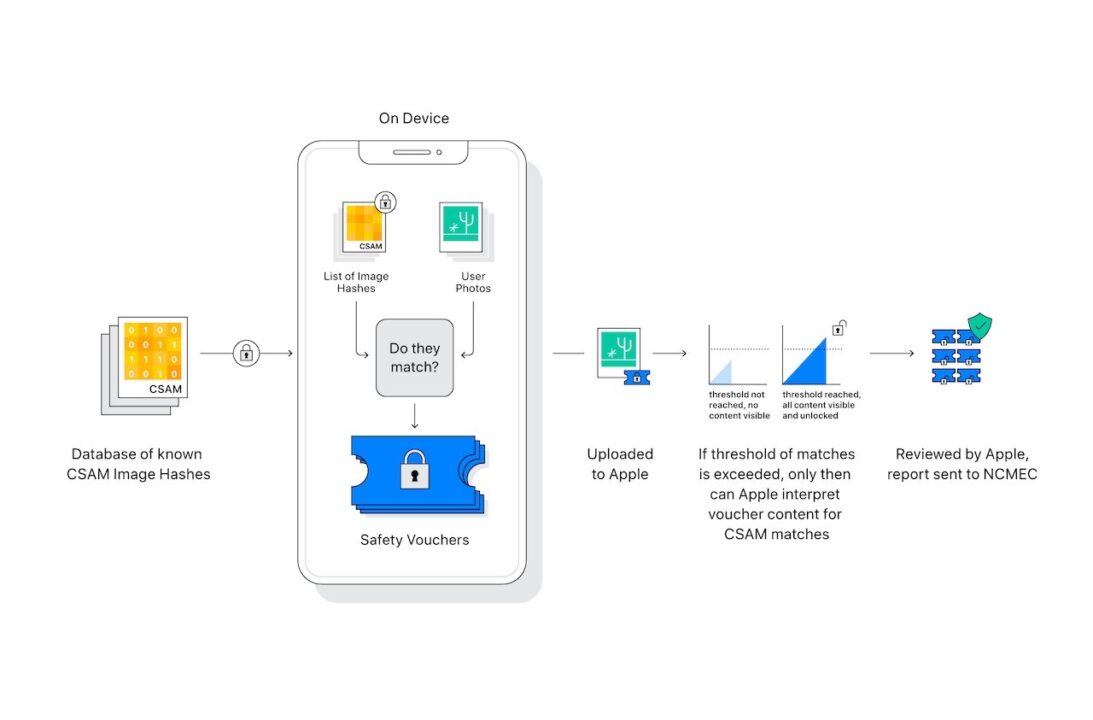

iCloud儿童性虐待内容检测

除此之外,Apple也采取了措施来解决儿童性虐待内容 (CSAM) 的传播,CSAM主要涉及了儿童的色情活动内容。

为了解决上述的问题,这项功能将允许Apple检测存储在iCloud照片中的CSAM图片,使Apple能够向国家失踪和受虐儿童中心 (NCMEC) 报告这些情况,NCMEC是CSAM的综合报告中心,将与美国各地的执法机构合作。

Apple将通过照片与NCMEC提供的儿童性虐待材料数据库进行对比,并检测虐待照片。如果负责审查的人员最终认为系统没有出错,那么Apple将会禁用上传违规图片的用户iCloud账号。如果用户认为他们的帐户被错误标记,也可以向该公司提出上诉。

Siri和搜索功能更新

Apple 还通过提供更多资源来帮助儿童和父母保持网络安全,如果在不安全的情况下,也能通过Siri和搜索功能获得帮助。

用户可以透过询问Siri如何报告儿童性虐待内容或儿童剥削,它将告诉用户可以在哪提交报告给有关部门。当孩子搜索儿童性虐待相关内容时,也会解释该主题是不洽当的,并提供咨询资源。

Siri和搜索的这项新功能也将于今年内在iOS 15、iPadOS 15、watchOS 8和macOS Monterey的更新中推出。