快科技5月29日消息,在刚刚召开的2023年台北电脑展上,NVIDIA首席执行官黄仁勋进行了演讲。

在演讲中,黄仁勋向传统的CPU服务器集群发起“挑战”,认为在人工智能和加速计算这一未来方向上,GPU服务器有着更为强大的优势。

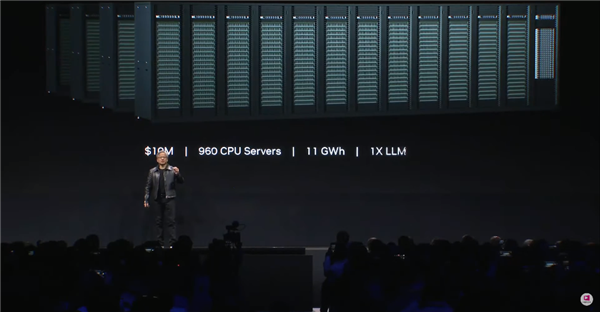

根据黄仁勋在演讲上展示的范例,训练一个LLM大语言模型,将需要960个CPU组成的服务器集群,这将耗费大约1000万美元(约合人民币7070万元),并消耗11千兆瓦时的电力。

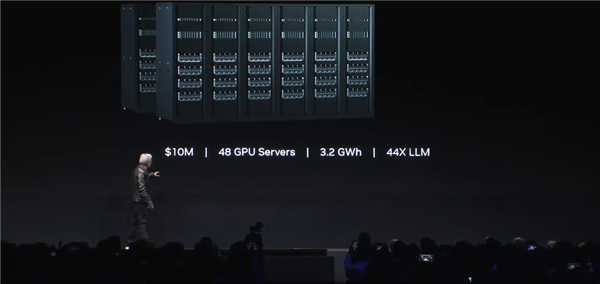

相比之下,同样以1000万美元的成本去组建GPU服务器集群,将以仅3.2千兆瓦时的电力消耗,训练44个LLM大模型。

如果同样消耗11千兆瓦时的电量,那么GPU服务器集群能够实现150倍的加速,训练150个LLM大模型,且占地面积更小。

而当用户仅仅想训练一个LLM大模型时,则只需要一个40万美元左右,消耗0.13千兆瓦时电力的GPU服务器即可。

换言之,相比CPU服务器,GPU服务器能够以4%的成本和1.2%的电力消耗来训练一个LLM,这将带来巨大的成本节省。

(本文授权转载自合作伙伴快科技)

Source :